Da facada à terra plana

“Eu me perguntava: ‘Como as pessoas podem ficar de cabeça para baixo e não cair?’ Nunca acreditei, apesar de ter precisado colocar nas provas escolares que a Terra era um globo.” Na boca de uma criança, a ponderação acima teria de ser confrontada com as armas da ciência e da paciência.

Foi proferida, entretanto, por um homem de 56 anos, como registrou reportagem desta Folha sobre a primeira Convenção Nacional da Terra Plana, a FlatCon, realizada domingo (10) em São Paulo.

O fato de um adulto alfabetizado prostrar-se diante das ilusões do senso comum pode ser atribuído, talvez, a falhas do sistema educacional, incapaz de ensinar fatos científicos básicos. Também seria aceitável argumentar que se trata de exceção irrelevante.

Havia cerca de 400 frequentadores pagantes na FlatCon. Supondo que poucos se aventurariam a desembolsar dinheiro para vincular-se de público a noções lógica e obviamente contrárias aos fatos, deduz-se que o contingente de terraplanistas não é tão diminuto assim.

De fato, pesquisa Datafolha de julho constatou que 7% dos brasileiros dizem acreditar que a Terra, em vez de esférica, tem formato de disco. Para mais de 10 milhões de pessoas, nada valem dados e documentos, sejam eles fotos tiradas do espaço ou voos de volta ao mundo, eclipses e fases da Lua.

Para cada evidência em contrário, o terraplanista encontrará explicação alternativa na indústria de vídeos, livros e memes em que opiniões têm o mesmo valor de fatos.

Essa franja de convicções excêntricas apresenta alguma superposição com grupos de índole conservadora que põem em dúvida outros fatos comprovados, como o aquecimento global ou a eficácia e a segurança de vacinas.

Espanta não só que tantos se professem refratários ao método científico, mas sobretudo que aceitem acreditar em ciclópicas conspirações globalistas. Livros didáticos, jornalistas, artigos científicos, professores, cartógrafos, engenheiros, agências espaciais, astronautas, pilotos —todos conjurados no engodo para incautos.

Parcelas cada vez mais visíveis do público se mostram propensas ao descrédito em fatos quando apresentados por aqueles de quem discordam por princípio. E errará quem daí concluir que a epidemia se propaga apenas à direita —do lado oposto há, por exemplo, quem acredite que a facada em Jair Bolsonaro (PSL) foi uma fraude.

https://www1.folha.uol.com.br/opiniao/2019/11/da-facada-a-terra-plana.shtml

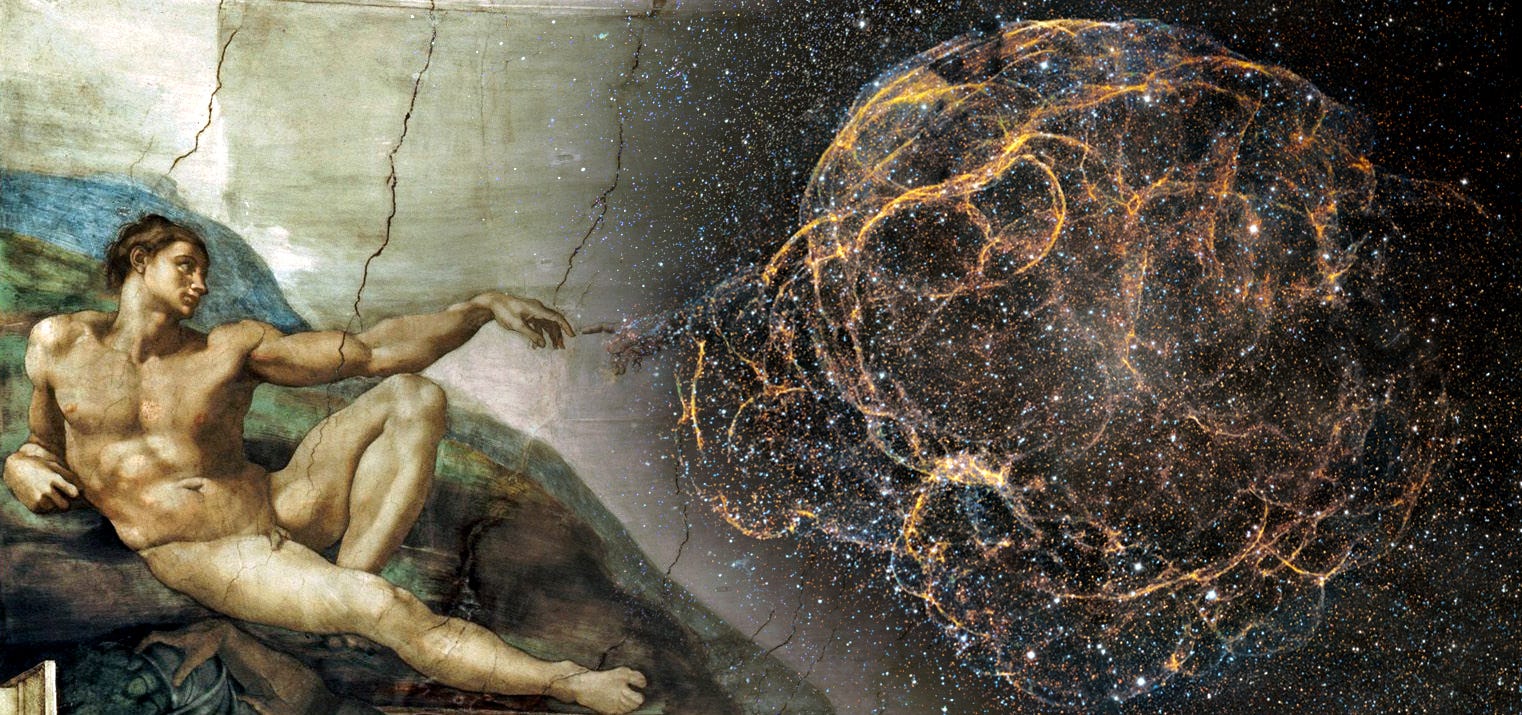

Os santos e a ciência

Incomoda o verniz científico que o Vaticano tenta imprimir aos processos de canonização

Compreendo que organizações religiosas precisem eleger modelos de vida virtuosa e mostrá-los conspicuamente aos fiéis, para que tentem imitá-los. É nesse contexto que se explicam santos, mártires, “stáriets”, taumaturgos e iluminados.

Não tenho nada contra a santificação de Irmã Dulce, que me parece mesmo uma figura simpática. Devo, porém, dizer que me incomoda o verniz científico que o Vaticano tenta imprimir aos processos de canonização, vinculando-os a milagres que passam pelo crivo de comissões de médicos e cientistas, incumbidas de atestar que o fenômeno não tem explicação natural. Há aí uma confusão epistemológica. Não encontrar uma explicação é muito mais uma medida de nossa ignorância do que a certeza de uma interferência sobrenatural.

Chega a ser suspeito o fato de que a maior parte dos milagres modernos venha da medicina, campo em que reina a incerteza. O diagnóstico inicial estava certo? Componentes psicológicos influíam no quadro do paciente? Em que medida a remissão de um tumor, por exemplo —algo que todos os grandes hospitais registram com doentes de todas as religiões e ateus—, pode ser considerada milagrosa? Por que nunca vimos uma cura que calaria a boca de todos os céticos, como a regeneração de um membro amputado?

E, se quisermos levar o espírito de porco da ciência mais longe, podemos questionar até as motivações dos santos. Suas boas ações são fruto de altruísmo genuíno ou apenas um instrumento para conquistar um lugar no paraíso? Mesmo que descartemos essa última hipótese, a ciência mostra que ajudar pessoas libera neurotransmissores que produzem a sensação de bem-estar, o que também pode ser interpretado como uma motivação egoísta. Isso, é claro, se acreditarmos no livre-arbítrio, sem o qual não existe santidade, mas que a ciência vê com desconfiança.

É melhor para a religião manter os santos longe do escrutínio da ciência.

Hélio Schwartsman

Jornalista, foi editor de Opinião. É autor de “Pensando Bem…”.

https://www1.folha.uol.com.br/colunas/helioschwartsman/2019/10/os-santos-e-a-ciencia.shtml

Carl Sagan e o prelúdio da nossa época

“A ciência é mais do que um corpo de conhecimento, é um modo de pensar. Tenho um pressentimento sobre a América do Norte dos tempos de meus filhos ou de meus netos – quando os EUA serão uma economia de serviços e informações; […] quando tremendos poderes tecnológicos estarão nas mãos de uns poucos, e nenhum representante do interesse público poderá sequer compreender de que se trata; quando as pessoas terão perdido a capacidade de estabelecer seus próprios compromissos ou questionar compreensivelmente os das autoridades; quando, agarrando os cristais e consultando nervosamente os horóscopos, com as nossas faculdades críticas em decadência, incapazes de distinguir entre o que nos dá prazer e o que é verdade, voltaremos a escorregar, quase sem notar, para a superstição e a escuridão.

O emburrecimento da América do Norte é muito evidente no lento declínio do conteúdo substantivo nos tão influentes meios de comunicação, nos trinta segundos de informações que fazem furor (que agora já são dez segundos ou menos), na programação de padrão nivelado por baixo, na apresentação crédula da pseudociência e da superstição, mas especialmente numa espécie de celebração da ignorância. […] A lição clara é que estudar e aprender – e não se trata apenas de ciência, mas de tudo o mais – é evitável, até indesejável.

Nós criamos uma civilização global em que os elementos mais cruciais – o transporte, as comunicações e todas as outras indústrias, a agricultura, a medicina, a educação, o entretenimento, a proteção ao meio ambiente e até a importante instituição democrática do voto – dependem profundamente da ciência e da tecnologia. Também criamos uma ordem em que quase ninguém compreende a ciência e a tecnologia. É uma receita para o desastre. Podemos escapar ilesos por algum tempo, porém mais cedo ou mais tarde essa mistura inflamável de ignorância e poder vai explodir na nossa cara.” (O Mundo Assombrado pelos Demônios. p. 43-44)

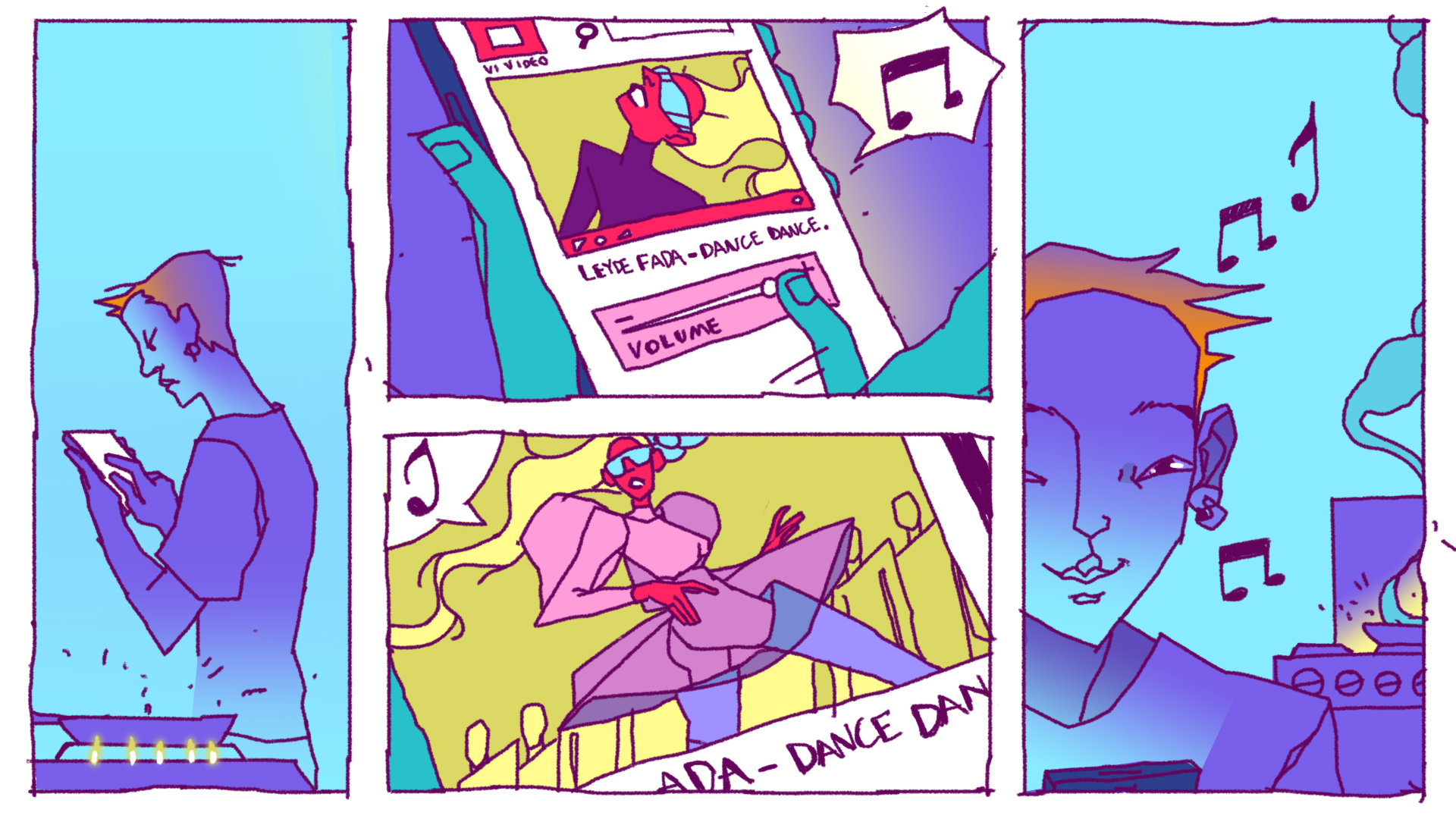

Mexendo com sua cabeça

Você pode não perceber, mas alguma coisa acontece no seu cérebro toda vez que a telinha do celular se ilumina. O aparelhinho já virou parte essencial do nosso corpo e mexe mesmo com a nossa central de controle: pode mudá-la, substituí-la em algumas funções ou condicioná-la a se comportar de determinada maneira.

O celular já é uma extensão do nosso cérebro. Você utiliza-o como parte da memória, como se fosse parte de você

Edgard Morya, pesquisador do Instituto Internacional de Neurociências Edmond e Lily Safra

Ao longo da história, outras tecnologias até moldaram nosso cérebro, mas nenhuma delas tinha tantos truques na manga ou se massificou como o smartphone.

Calma, não é o fim do mundo. Toda essa mudança não é necessariamente ruim, já que o cérebro é mestre em adaptações e deve tirar isso de letra.

Mas e você? Tira de letra a sua relação de dependência com o celular?

Como age o cérebro

Antes de entender o casamento entre smartphone e cérebro, é bom analisar como agem os noivos.

O órgão humano tem diversas habilidades, mas uma é crucial para entender essa relação com os celulares: a plasticidade, ou seja, a capacidade de ele adaptar sua estrutura para desempenhar novas funções ou criar soluções caso sofra alguma lesão.

Isso faz com que ele mude, adapte-se e molde-se tanto no nível estrutural (nos axônios que ligam os neurônios), quanto no funcional (na comunicação entre os neurônios). O cérebro precisa mudar para que a gente consiga aprender algo, senão nada feito. Quando você aprende a escrever um texto no papel, é necessário que aconteça uma adaptação neurofisiológica. E, de adaptação em adaptação, vamos ganhando novas habilidades, perdendo algumas no caminho ou reduzindo conhecimentos já adquiridos. Isso é perfeitamente normal –pelo menos do ponto de vista neurológico.

Como você já deve ter percebido, é essa neuroplasticidade que faz com que o cérebro aprenda rapidamente os segredos do celular e mude algumas de suas estruturas por causa do aparelho.

Todo mundo que aprende a ler perde um pouco a capacidade de reconhece faces. Analfabetos possuem melhor desempenho no reconhecimento de faces do que os letrados, mas que lê ganha uma maneira de comunicação e armazenamento de informação. Uma mudança no nosso cérebro não necessariamente vem a ser uma coisa ruim

O efeito do smartphone na mente

sso já aconteceu antes com outras tecnologias, da escrita e dos livros aos meios magnéticos de armazenamento de informação, também conhecidos como HDs, que, cada um a seu tempo, substituíram algumas funções da memória.

Mas nunca com a intensidade observada agora, explica Guimarães. E há aqui duas explicações:

- A massificação do smartphone tornou-o um acessório individual.

- Cada recurso do aparelho é capaz de estimular o cérebro de diferentes maneiras, da tela à câmera, da calculadora ao bloco de notas.

Interagir com um aparelho cheio de funções faz com que seu cérebro tenha de se especializar para aprender dezenas de recursos. Só que, ao fazer isso, ele entende o aparelho como um adendo de si. É algo parecido com o que acontece com a raquete de tênis para um tenista profissional ou com o piano para um pianista, explica Morya. “Ele não precisa saber onde está uma tecla, já que o piano é como se fosse parte do corpo dele.”

Agora faça um exercício mental: pense em quantos pianistas você conhece. E donos de celular? Eis o poder de contágio do celular. “Quanto mais tempo a pessoa passa com o telefone, mais a área que representa os dedos no cérebro vai crescer e ficar ágil, por causa da tela sensível ao toque e das funcionalidades que exigem a movimentação dos dedos”, ressalta Weingartner.

O smartphone atinge áreas no cérebro que um telefone normal não atingia. Há todo um estímulo visual trazido pela tela, o que já modifica a relação do equipamento com o cérebro, e há o desenvolvimento da parte motora pra aprender a mexer, o que celulares analógicos não traziam

Aparelho vira extensão da nossa memória

Como todo apaixonado, após cair nas garras desse amor gostoso com o smartphone, o cérebro começa a mudar de comportamento. Como são muitas, vamos passear por elas uma a uma, mas não é assim que acontece na vida real. Tudo ocorre simultaneamente.

Os especialistas são unânimes em diz que os celulares inteligentes já são responsáveis por executar uma função muito íntima do seu sistema cognitivo: a memória. “De quantos números de celular você lembra agora? Eu mal lembro o meu e o da minha mãe. Antigamente, a gente sabia o telefone de todo mundo”, brinca Guimarães.

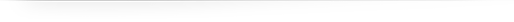

O exemplo é simples, mas a explicação para o esquecimento de pequenos detalhes mostra como o processo não é banal. Seu cérebro divide as memórias em dois subgrupos:

- As de curto prazo, chamadas de memória de trabalho. Você usa-as por tempo suficiente para lidar com uma tarefa. Por exemplo: em um problema de lógica, caso você não memorize momentaneamente as condicionantes do problema, não vai conseguir solucionar a questão.

- As de longo prazo, aquelas que duram um pouquinho mais. Essas também se dividem em dois grupos, a das memórias declarativas (fatos ou episódios) e as não-declarativas (conceitos, habilidades e aprendizados associativos).

Nossa memória ganha um HD externo

O que acontece agora é que informações como números de telefone, antes registradas no seu cérebro como memórias de longo prazo declarativas, passaram a ser guardadas no seu celular. Isso vale também para outras recordações, como lembranças de viagens, shows ou festas, que praticamente não existem se não forem registradas em uma foto.

“Vamos supor que eu queira lembrar dos momentos que eu passei com meu irmão quando ele veio me visitar. Isso está registrado na minha memória, ainda que eu não possa ver, porque a memória de longo prazo é uma fonte de armazenamento não acessível”, diz Weingartner. Mas ter um celular registrando esse momento modifica essa nossa relação com essa memória, porque passamos a acessá-la quando ela não está só registrada no cérebro.

Por isso, os neurocientistas classificam o celular com uma extensão do hipocampo, estrutura localizada nos lobos temporais e considerada a central da memória.

O lado bom é que, ao criar um histórico de lembranças que podem ser consultadas com um toque, o celular ajuda a consolidarmos algumas memórias. Como nossa capacidade cognitiva é limitada (estudos apontam que nosso cérebro processa só 60 bits por segundo), os especialistas julgam que delegar parte da memória de longo prazo aos smartphones não é tão danoso.

A memória é usada para tudo. Você precisa da memória para fazer uma conta, mas se fizer uma previsão matemática de um modelo científico vai usar não só a memória como outras áreas do cérebro. O celular substitui isso? Não

Dopamina na veia vicia

Claro que nem todas as interações do smartphone com seu cérebro são úteis ou saudáveis. O aparelho é todo pensando para fazer você ficar louco para pegá-lo o tempo todo. A consultora norte-americana em neuropsicologia Susan Weinschenk, autora do livro “Neuro Web Design – What Makes Them Click?” (“Neuro Web Design – O que os faz clicar”, em tradução literal), chama esses truques de “gatilhos neurológicos”.

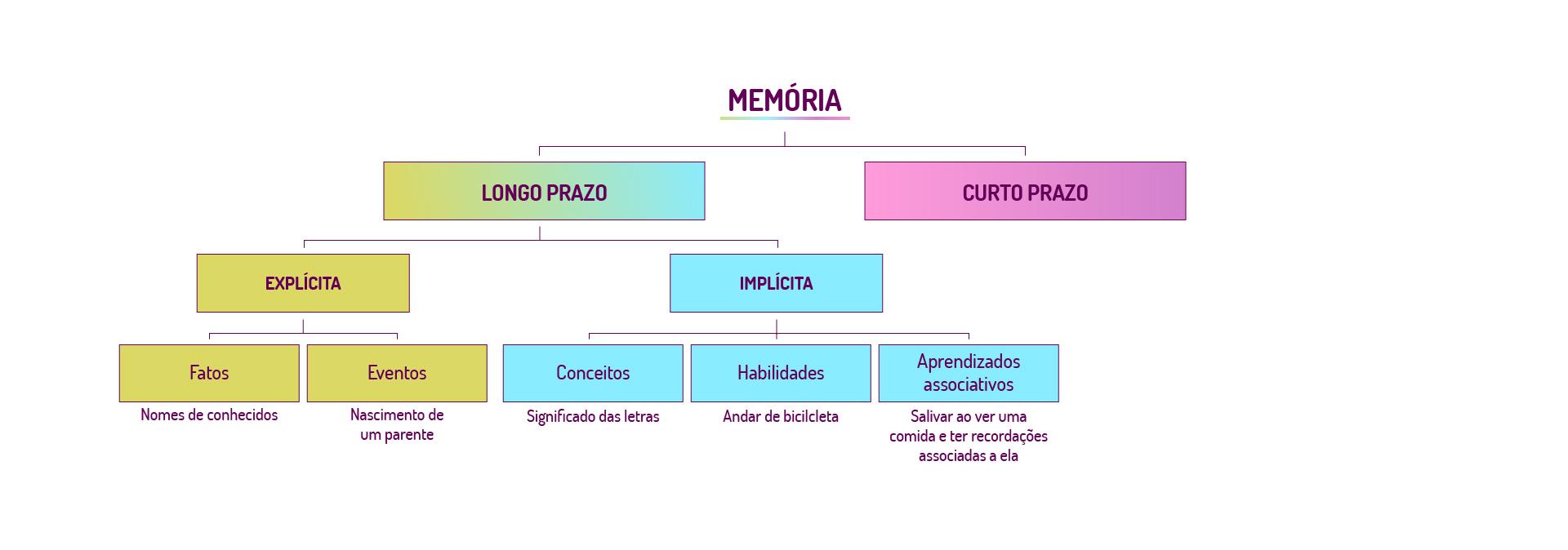

Funciona assim: todas as vezes que pinta alguma notificação no seu celular, você libera dopamina. Esse neurotransmissor é responsável em alguma medida pela sensação de prazer. Alguns alertas, em especial, como sinalizações de “curtidas” ou comentários em postagens que você fez, geram ainda mais prazer.

“Você faz uma ação, tem a liberação de um neurotransmissor e se sente bem. A tendência é querer fazer isso mais vezes”, diz Morya.

Então, se você já se pegou rolando o feed no Facebook ou no Instagram por horas e horas sem objetivo nenhum ou querendo loucamente postar algo, saiba que você caiu em uma armadilha. É o ‘loop de dopamina’, um ciclo vicioso de bem-estar que faz seu cérebro esquecer do mundo.

O smartphone deixa a gente conectado 24 horas por dia, recebendo uma injeção de neurotransmissores cada vez que apertamos a bolinha do celular

Estresse causado pelo tsunami de notificações

Só que seu cérebro não é bobo. Ao notar essa inundação de dopamina, ele cria uma trava para impedir que qualquer meia dúzia de curtidas leve você ao êxtase. Parece ótimo, mas o estímulo precisa ser cada vez maior para que você tenha a mesma sensação de prazer. Aí vira uma armadilha.

Além disso, o sistema que libera os neurotransmissores é sensível a indícios de que algo agradável está prestes a acontecer. Ou seja, basta uma notificação para que fique em estado de alerta. Entra em cena uma dose de outro neurotransmissor, o cortisol, aquele que induz ao estresse.

Esse processo vai condicionando nosso cérebro a aguardar que pintem notificações no celular. “Isso gera bastante ansiedade e faz que algumas pessoas fiquem o tempo todo checando se há coisa nova no celular”, afirma Brizante.

Toma, distraído!

Essa constante expectativa pelo surgimento de uma notificação gera outro efeito. Além de manter os donos de celulares em constante estado de alerta, deixa-os desatentos.

“A questão da atenção é brutal”, comenta Marília Zaluar Guimarães. Ela cita estudos em que pesquisadores demonstraram que a capacidade cognitiva é seriamente afetada pela simples presença do celular. Eles testaram alunos em três situações diferentes: com o celular posicionado em cima mesa, com o celular na bolsa/bolso ou com o celular fora sala em que estavam. Aplicaram provas sobre o conteúdo ensinado nesses três momentos.

O desempenho dos estudantes melhorou à medida que o aparelho foi se distanciando. Agora, um detalhe chocante: o pior resultado dos alunos foi com os celulares em cima da mesa, ainda que estivessem virados para baixo. Ou seja, mesmo sem ver a tela, o aparelho já é uma distração por todos os gatilhos neurológicos armados previamente no cérebro.

Esse efeito persiste também com o aparelho desligado, principalmente quando se exige a concentração em uma só atividade. Pesquisadores da Universidade Stanford descobriram que jovens acostumados à enxurrada de estímulos gerada pelo celular têm cérebros mais preguiçosos e com menor capacidade de ignorar informações irrelevantes. “Eles são sedentos por irrelevância”, afirmou o professor Clifford Nass, um dos pesquisadores, à revista “Proceedings of the National Academy of Sciences”.

Em testes, os acadêmicos constataram que esses indivíduos não conseguem memorizar dados simples, como letras que se repetem. As informações vistas nesse troca-troca de tarefas não chegam nem a virar memórias de curto prazo, o que dificulta a consolidação de um aprendizado.

Crise no relacionamento: atarefados e desatentos

O poder dos smartphones de executar inúmeras funções é outra coisa que mexe com seu cérebro. Parece bom poder tocar música, enviar mensagens e jogar sem trocar de aparelho. Mas toda vez que você pula de um app para outro, seu cérebro paga um “pedágio” em capacidade de processamento.

O psicólogo norte-americano David Meyer, professor da Universidade de Michigan, estima que a troca intensa entre atividades pode comprometer até 40% do tempo produtivo do cérebro.

A mudança constante para uma nova função, aparentemente mais atrativa que a anterior, também está relacionada ao ‘loop da dopamina’. Seu cérebro se interessa por uma nova atividade em busca de algo prazeroso, que vá liberar mais dopamina e renovar a sensação de bem-estar.

Só que a interrupção de uma atividade possui efeitos negativos. Isso injeta doses de cortisol, o que eleva os níveis de estresse, segundo estudos do endocrinologista e professor de pediatria na Universidade da Califórnia Robert Lustig.

A alternância de tarefas vai tornando as pessoas mais ‘rasas’ por não conseguirem fazer associações mais profundas

Quero um pote de biscoito, imediatamente

Atire o primeiro like quem nunca passou por isso: você posta algo nas redes sociais e, segundos depois, surge na tela do seu celular uma resposta, em forma de “curtida”, comentário ou novos seguidores. Bom, né?

Os especialistas chamam isso de gratificação imediata, e seu efeito é um dos mais preocupantes, pois leva a um desequilibro emocional.

“Isso faz com que a gente perca a capacidade de se dedicar a uma coisa cuja gratificação vai demorar muito a chegar”, explica Marília Zaluar Guimarães. “As pessoas acostumadas a essa rapidez do smartphone não conseguem lidar com a frustração diante da espera por uma resposta. Ou passam a repudiar atividades que não recompensem imediatamente o esforço empreendido.”

E, por enquanto, somente uma tecnologia é capaz de dar esse nível de gratificação em tempo real, onde quer que você esteja: o celular. É o feedback portátil, que faz parte de você, resume Morya.

Mas, vamos deixar claro que apesar de bagunçar sua cabeça de diversas formas, o smartphone é uma ferramenta revolucionária. Para os especialistas consultados por Tilt, o aparelho ampliou o poder de comunicação, de acesso a informação e colocou na mão de cada um uma grande capacidade computacional.

“Tem gente que diz que o celular tira o treinamento do cérebro, que faz mal”, analisa Morya. “Pode fazer, se você deixar de usá-lo para funções mais complexas. O celular é uma ferramenta aliada: você pode deixar funções corriqueiras para fazer nele e usar seu cérebro em atividades mais complexas.”

Direção de Arte: Suellen Lima; Edição: Fabiana Uchinaka; Ilustração: Eryk Souza; Infografia: Elias Fernandes; Motion Design: Daniel Neri.

Fonte: https://www.uol.com.br/tilt/reportagens-especiais/como-o-smartphone-muda-seu-cerebro/index.htm

Por que o Vaticano, coração da Igreja, sedia a maior conferência sobre ateísmo no mundo

Desta terça (28) até quinta-feira (30), o Vaticano, centro espiritual e político da Igreja Católica, sedia um evento inusitado, se considerarmos seus princípios. Trata-se da Understanding Unbelief, apresentada como a maior conferência mundial sobre ateísmo.

O programa, financiado pela Fundação John Templeton, é organizado por quatro instituições acadêmicas, todas do Reino Unido. Na coordenação está a Universidade de Kent. E colaboram as universidades Conventry, Queen’s e de Saint Mary.

“Este evento não se realizaria no Vaticano se não fosse por uma efeméride: trata-se do 50º aniversário de uma conferência semelhante realizada no Vaticano”, afirmou à BBC News Brasil o antropólogo Jonathan Lanman, diretor do Instituto de Cognição e Cultura e professor da Universidade Queen’s Belfast, um dos organizadores do evento.

Ele contou que um dos pesquisadores entrou em contato com o Vaticano, e então “eles concordaram em revisitar os temas da ‘incredulidade'”.A conferência de 1969, a primeira do gênero sobre o tema, ocorreu como consequência da abertura provocada pelo Concílio Vaticano 2º, ocorrido de 1962 a 1965.

O papa Paulo 6º (1897-1978) era um entusiasta do diálogo com outros cristãos, judeus e adeptos de outras religiões. E também criou um secretariado próprio para ouvir a quem chamava de “descrentes” —segundo suas palavras, o ateísmo era “um dos assuntos mais sérios de nosso tempo”.

O papa Francisco, que comanda a Igreja Católica desde 2013, já deu mostras de que procura abordar os ateus de forma respeitosa e sem um discurso de oposição.

No início deste ano, por exemplo, ele disse que é melhor viver como ateu dos que ir à missa e nutrir ódio pelos outros.

“Quantas vezes vemos o escândalo das pessoas que passam o dia na igreja e depois vivem a odiar ou a falar mal dos outros”, afirmou ele.”Vive como um ateu. Mas se vais à igreja, então vive como filho, como irmão, dá um verdadeiro exemplo.”

O evento que começa nesta terça terá painéis que debaterão o que leva pessoas a crerem e o que leva pessoas a não crerem em deus. Participam maioritariamente pesquisadores acadêmicos interessados no tema, como sociólogos, antropólogos, teólogos e filósofos —mas religiosos também são bem-vindos.

Em outubro de 2018, ele havia condenado publicamente o fato de muitos católicos lavarem dinheiro sujo, explorarem seus funcionários e cometerem delitos. “Há muitos católicos que são assim e eles causam escândalos”, disse o pontífice. “Quantas vezes todos ouvimos pessoas dizerem ‘se esta pessoa é católica, é melhor ser ateu’?”.

O evento desta semana tem a chancela do Pontifício Conselho para a Cultura, dicastério criado em 1982 pelo papa João Paulo 2º (1920-2005).

Há 50 anos, a primeira conferência foi, segundo o sociólogo Rocco Caporale (1927-2008), que escreveu um livro sobre ela (‘The Culture of Unbelief: Studies and Proceedings From the First International Symposium on Belief Held at Rome’), uma primeira oportunidade para que a Igreja pudesse debater várias questões da “cultura da não-crença” e sobre como estudá-la.

Caporale relata que uma das principais percepções dos participantes do simpósio de 1969 foi a de que “o crer e o não crer são uma completa terra incógnita”.

Mas, dessa vez, o pesquisadores poderão se debruçar sobre os dados de um estudo realizado pelas universidades britânicas de Kent, Conventry, Queen’s e Saint Mary.

Trata-se de uma pesquisa conduzida em seis países sobre o que é ser ateu hoje. No total, foram entrevistadas 6,6 mil pessoas —seguindo criteriosa amostragem científica— do Brasil, Estados Unidos, Reino Unido, China, Japão e Dinamarca.

O relatório, que será publicado nesta terça (28), trouxe oito pontos-chave para entender o fenômeno da não-crença no mundo:

1. Ateus —aqueles que não acreditam em deus— e agnósticos —os que não sabem se existe deus ou não, mas não acreditam que haja uma maneira descobrir— não são homogêneos. Eles aparecem em grupos diferentes nos países pesquisados. “Por conseguinte, há muitas maneiras de ser incrédulo”, pontua o documento.

2. Em todos os seis países, a maioria dos que não acreditam em deus se identifica como “sem religião”.

3. Na hora de se autorrotularem, os incrédulos que preferem ser chamados de “ateu” ou “agnóstico” não são a maioria. Muitos classificam-se como “humanistas”, “pensadores livres”, “céticos” ou “seculares”.

4. Os ateus do Brasil e da China são os menos convencidos de que sua crença sobre a não-existência de deus está correta.

5. Não crer em deus não significa necessariamente não acreditar em outros fenômenos sobrenaturais, ainda que os ateus sejam mais céticos em relação a estes do que as populações gerais.

6. Entre os ateus, o percentual de pessoas que acham que o universo é “em última instância, sem sentido” é maior do que no restante da população. Mas, ainda assim, em número muito inferior ao de metade dos pertencentes ao grupo.

7. Quando confrontados com questões relacionadas a, segundo o relatório, “valores morais objetivos, dignidade humana e direitos correlatos, além do valor profundo da natureza”, as posições dos ateus são semelhantes ao do restante da população.

8. Por fim, quando perguntados sobre quais são os valores mais importantes da vida, houve uma “concordância extraordinariamente alta entre incrédulos e populações gerais”, apontou o levantamento. “Família” e “liberdade” foram muito bem citados por todos, além de “compaixão”, “verdade”, “natureza” e “ciência”.

Da mesma maneira que nem todos os que se descrevem como “sem religião” são ateus —muitos cultivam uma espiritualidade própria— a pesquisa mostrou que nem todos os ateus são “sem religião”.

No caso do Brasil, por exemplo, 73% dos incrédulos se identificam como “sem religião”, enquanto 18% se dizem cristãos. Na Dinamarca, 63% dos ateus se dizem “sem religião” —28% são cristãos.

A explicação para isso pode ser por conta da tradição familiar. Com exceção dos chineses e dos japoneses, a maioria dos ateus entrevistados disseram que romperam uma religião de família —é o caso de 85% dos incrédulos brasileiros e 74% dos norte-americanos, por exemplo.

Em todos os países ouvidos, a grande maioria dos ateus veio de famílias cristãs (79% dos brasileiros, 63% dos norte-americanos, 60% dos dinamarqueses).

A questão dos rótulos também traz variações —muitas vezes motivadas por receio de preconceitos. Entre os que “não sabem se deus existe” —tecnicamente agnósticos, portanto—, 8% dos brasileiros se autodefinem como ateus e a maioria, 27%, prefere ser chamada de agnóstica; seguida de não religiosa (16%), espiritual mas não religiosa (13%), racionalista (9%) e cética (8%).

Para os chineses desse grupo, 20% se dizem ateus e 18% racionalistas. Japoneses, britânicos e dinamarqueses preferem ser classificados como “não religiosos” (34% e 27% e 17%, respectivamente) e norte-americanos se definem como “agnósticos” (26%).

Já no grupo dos que afirmam que “deus não existe” —tecnicamente ateus— 30% dos brasileiros se autodenominam ateus, 14% sem religião. Situação semelhante aparece na pesquisa realizada com norte-americanos —39% assumem-se ateus.

E entre os chineses, há um equilíbrio entre os que preferem ser chamados de racionalistas, ateus e livres-pensadores (respectivamente com 22%, 21% e 19%). Dinamarqueses, britânicos e japoneses preferem ser classificados como sem religião (36%, 35% e 31%).

A crença na ciência como o melhor modelo para atingir o conhecimento apareceu como homogênea entre crentes e incrédulos em todos os países aferidos, exceto Brasil e Estados Unidos. No caso brasileiro, os métodos científicos são considerados o melhor caminho para 71% dos não crentes —contra 43% da população em geral.

Entre os norte-americanos, o número é de 70% entre os incrédulos e despenca para apenas 33% da população em geral.

“Essas descobertas mostram de uma vez por todas que a imagem pública do ateu é, na melhor das hipóteses, uma simplificação. E, na pior das hipóteses, uma caricatura bruta”, ressalta Lois Lee, pesquisadora de estudos religiosos da Universidade de Kent e autora dos livros Recognizing the Non-religious: Reimagining the Secular (Reconhecendo o Não-religioso: Reimaginando o Secular, em tradução livre) e The Oxford Dictionary of Atheism (O Dicionário Oxford de Ateísmo).

“Em vez de confiar em suposições sobre o que significa ser ateu, podemos agora trabalhar com uma compreensão real das diferentes visões de mundo que a população ateísta inclui.

As implicações para a política pública e social são substanciais. “Nossos dados vão de encontro a estereótipos comuns sobre os incrédulos”, afirma Lanman.

“Uma visão comum é que os incrédulos não teriam um senso de moralidade e propósito objetivos, nutrindo um conjunto de valores muito diferente do restante da população. Nossa pesquisa mostra que nada disso é verdade. Em um tempo em que as sociedades parecem estar cada vez mais polarizadas, tem sido interessante e encorajador ver que uma das supostas grandes divisões na vida humana —crentes x não crentes— pode não ser tão grande assim.”

https://www1.folha.uol.com.br/mundo/2019/05/por-que-o-vaticano-coracao-da-igreja-sedia-a-maior-conferencia-sobre-ateismo-no-mundo.shtml

Charlatães

Todo charlatão que se preza alega receber eflúvios energéticos do além túmulo. Em busca de alívio para os mais variados males, os crédulos vão até ele.

Basta correr o primeiro boato de que o parente do filho do amigo de algum vizinho sarou ao receber um passe para que a fama do charlatão se espalhe. Em pouco tempo, começam as romarias em sua porta.

Se o espertalhão aprendeu certos truques há mais de um século desmascarados pelos mágicos, como enfiar tesouras em narizes, raspar córneas e fazer cortes superficiais através dos quais retiram falsos tumores sem que os incautos sintam dor ou se deem conta da prestidigitação, os testemunhos de poderes extrassensoriais correm o mundo.

A credulidade humana não tem nacionalidade nem respeita fronteiras.

Ele se alimenta da insegurança do outro. Apregoa o dom de incorporar “entidades” que mobilizam energias transcendentais, capazes de restabelecer a ordem nas células do organismo enfermo.

Ninguém questiona a natureza dessa energia: cinética, térmica, potencial, atômica? Ninguém estranha por que ela não faz um tapete voar nem ferver a água de um copo.

O prestígio do charlatão é potencializado pelas personagens públicas que consegue atrair. Cada médico, juiz, presidente da República, intelectual ou artista de renome que procura seus serviços atrai publicidade e lhe confere atestado de idoneidade espiritual.

As motivações que levam gente esclarecida a ir atrás do sobrenatural são as mesmas que mobilizam a pessoa mais simplória. Credulidade é condição contagiosa, não respeita escolaridade, posição social, cultura ou talento artístico.

Trato de doentes com câncer há 50 anos. Assisti ao desapontamento de inúmeras famílias que viajaram centenas de quilômetros com seus entes queridos —muitas vezes debilitados— atrás da promessa de curas mágicas que jamais se concretizaram.

A vítima se aproxima do charlatão na esperança de um milagre. Poucos se conformam com a finitude da existência e aceitam as restrições impostas pelas leis da natureza: milagres não existem, são criações do imaginário humano.

Se existissem, em meio século de atividade profissional intensa com pacientes graves, eu teria visto pelo menos um, ainda que fosse uma redução ínfima nas dimensões de uma metástase. Cem por cento das chamadas curas espirituais que tive a oportunidade de avaliar não resistiram à análise racional mais elementar.

Como nem sempre estão bem definidos os limites de separação entre superstições, crendices e religião, quem ousa denunciar as artimanhas do charlatão é tido como contestador da religiosidade alheia e enfrenta a ira popular.

Duvidar da eficácia de suas ações é afrontar a palavra do “enviado de Deus” e as convicções dos fiéis. Tentar convencê-los de que são ludibriados por um malandro que lhes incute esperanças vãs é considerado sacrilégio.

Veja o caso desse cidadão autodenominado João de Deus. Durante décadas iludiu, trapaceou e cortou pessoas com instrumentos inadequados sem o menor cuidado com a esterilização.

Para retirar um ponto cirúrgico de um paciente em meu consultório, preciso de autorização explícita da Anvisa, sem a qual posso ser multado pela fiscalização caso guarde no armário uma pinça e uma tesoura cirúrgica. Tanto rigor com os médicos e permissividade covarde e conivente com esses incorporadores de espíritos.

A menos que tenha mediunidade suficiente para imobilizar vírus e bactérias, quantas infecções locais e transmissões de hepatite B e C, HIV e outras doenças esse curandeiro provocou impunemente?

A sociedade fica chocada ao saber que ele abusou de centenas de mulheres indefesas. Sinceramente, só me surpreendi com o número: esperar comportamento ético de alguém que ficou milionário explorando a boa fé de milhões de doentes é ingenuidade pueril.

Veja você, caríssima leitora, a situação humilhante da mulher no Brasil: no decorrer de 40 anos, um homem branco e poderoso se aproveita sexualmente de mulheres em situação de vulnerabilidade, sob o olhar complacente de auxiliares que com ele convivem, sem ser denunciado à polícia.

Não fossem os depoimentos apresentados no programa do Pedro Bial, quantas ainda seriam estupradas?

Que sensação de impotência, fragilidade, solidão e vergonha tantas mulheres viveram sem ter como reagir, com medo da opinião pública, acuadas pela influência religiosa e social de um criminoso desprezível.

Drauzio Varella

Médico cancerologista, autor de “Estação Carandiru”.

Fonte: https://www1.folha.uol.com.br/colunas/drauziovarella/2018/12/charlataes.shtml

A Era da Burrice

“Não há possibilidade de deus” diz Stephen Hawking

De sua mesa na Universidade de Cambridge e além, Stephen Hawking enviou sua mente espiralando nas maiores profundezas dos buracos negros, irradiando através do cosmos infinito num grande vórtice através de bilhões de anos para testemunhar a primeira respiração do tempo. Ele viu a criação como um cientista, e quando foi chamado para discutir os grandes enigmas da criação – De onde viemos? Qual o nosso propósito? Estamos sozinhos? – Ele respondeu como um cientista, muitas vezes para o desgosto dos críticos religiosos.

Em seu livro final “Pequenas Respostas para Grandes Perguntas” o professor Hawking inicia uma série de 10 ensaios intergaláticos ao lidar com a mais antiga – e mais religiosamente carregada – pergunta de todas: Existe um deus?

A resposta de Hawking – garimpada de décadas de entrevistas, ensaios e discursos com o auxílio de sua família, colegas e do Instituto Stephen Hawking – não deveria ser uma surpresa para os leitores que seguiram seu trabalho, digamos, religiosamente.

“Eu penso que o universo foi espontaneamente criado do nada, de acordo com as leis da ciência”, escreveu Hawking, falecido em Março. “Se você aceitar, assim como eu, que as leis da natureza são fixas, então não demora muito para se questionar: Qual o papel que existe para deus?”.

Em vida, Hawking foi um defensor aguerrido da Teoria do Big Bang – a ideia de que o universo começou de uma explosão súbita oriunda de uma singularidade ultradensa menor que um átomo. Deste ponto emergiu toda a matéria, energia e espaço vazio que o universo teria, e todo este material cru evoluiu para o cosmos que nós percebemos hoje ao seguir um conjunto estrito de leis científicas. Para Hawking e muitos cientistas que seguem a mesma filosofia, as leis combinadas da gravitação, relatividade, física quântica e mais algumas outras poderia explicar tudo que já ocorreu e que ocorrerá em nosso universo.

“Se te agrada, você pode dizer que as leis são um trabalho de deus, mas isso é mais uma definição de deus que uma prova de sua existência”, escreveu Hawking.

Com o universo funcionando num piloto automático cientificamente guiado, o único papel para uma toda poderosa deidade poderia ser determinar as condições iniciais do universo, para que as leis tomassem forma – um criador divino que fez o Big Bang explodir, e então deu um passo para trás para observar o próprio trabalho.

“Será que deus criou as leis quânticas que permitiram a ocorrência do Big Bang?” escreveu Hawking. “Eu não tenho o desejo de ofender as pessoas de fé, mas penso que a ciência tenha uma explicação mais convincente que um criador divino”.

As explicações de Hawking começam com mecânica quântica, que explica como as partículas subatômicas se comportam. Em estudos quânticos, é comum ver partículas subatômicas como prótons e elétrons surgirem – aparentemente do nada, passearem um pouco e então desaparecer novamente em uma localização completamente diferente. Como o universo já foi do tamanho de uma partícula subatômica, é plausível que se comportou de maneira similar durante o Big Bang, escreveu Hawking.

“O próprio universo, em sua incompreensível vastidão e complexidade, poderia simplesmente ter surgido subitamente sem violar nenhuma lei conhecida da natureza”.

Isso ainda não explica a possibilidade de deus ter criado uma singularidade do tamanho de um próton, e então ter puxado a alavanca que ligou a mecânica quântica, fazendo com que o universo surgisse. Mas Hawking diz que a ciência também possui uma explicação para isso. Para ilustrar, ele utiliza a física de buracos negros – estrelas colapsadas tão densas que nem mesmo a luz consegue fugir do seu campo gravitacional.

Buracos negros, como o universo antes do Big Bang, condensam numa singularidade. Neste ultradenso ponto de massa, a gravidade é tão forte que distorce o tempo assim como a luz e o espaço. De maneira simples, nas profundezas de um buraco negro o tempo não existe.

Como o universo também começou como uma singularidade, o tempo não poderia ter existido antes do Big Bang. A resposta de Hawking, então, ao quê aconteceu antes do Big Bang é “não existia tempo antes do Big Bang”.

“Finalmente encontramos algo que não possui uma causa, porque não havia tempo para uma causa pudesse existir”, escreveu Hawking. “Para mim isso significa que não existe a possibilidade de um criador, porque não havia tempo para que um criador pudesse existir.”

Este argumento fará pouco para persuadir crentes teístas, mas esta nunca foi a intenção de Hawking. Como um cientista com uma devoção quase religiosa de compreender o cosmos, Hawking procurou “conhecer a mente de deus” ao aprender tudo que pôde sobre a autossuficiência do universo à nossa volta. Enquanto sua visão possa tornar um criador divino e as leis da natureza como coisas incompatíveis, ainda deixa um amplo espaço para fé, esperança, questionamentos e – especialmente – gratidão.

“Nós possuímos esta única vida para apreciar o grande design do universo,” Hawking conclui no primeiro capítulo de seu último livro, “e sou extremamente grato por isto”.

Publicação original

https://www.livescience.com/63854-stephen-hawking-says-no-god.html

Tradução by David R. José.

O Nobel que ajudou a desenvolver a física no Brasil e pulou Carnaval

O dia 11 de maio deste ano marca o centenário de um dos cientistas mais influentes do século 20: o norte-americano Richard Feynman (1918-1988), que se destacou por seus estudos seminais em vários domínios da física teórica, em particular física quântica e de partículas e teoria do hélio líquido superfluido.

Extraordinariamente criativo e original, Feynman recebeu o Prêmio Nobel de Física em 1965 (com Julian Schwinger e Sin-Itiro Tomonaga) pelas contribuições independentes ao desenvolvimento da teoria da eletrodinâmica quântica. Em 1999, em pesquisa realizada com físicos de todo o mundo, foi considerado um dos dez cientistas mais importantes de todos os tempos.

Em 1966, fez uma célebre palestra com o título “Há muito espaço lá embaixo”, na qual chamou a atenção para o enorme potencial tecnológico existente na escala atômica. Ela é considerada o ponto de partida de um novo ramo: a nanotecnologia.

Em 1986, teve papel de destaque na comissão que investigou as causas do acidente da nave espacial Challenger. Fez uma brilhante demonstração pública sobre o efeito da baixa temperatura nas vedações de borracha do tanque de combustíveis.

Seu espírito crítico, ao contestar avaliações anteriores do acidente, levou-o a enunciar uma definição mordaz: “A ciência é a crença na ignorância dos experts”.

Feynman esteve no Brasil algumas vezes —a primeira em 1949, a última em 1966. Apreciador da música em geral e do samba em particular, que considerava um ritmo alegre e espontâneo, desfilou em bloco carnavalesco do Rio de Janeiro em 1952. Educador inveterado, lecionou por aqui e deu importante contribuição nos primórdios da física teórica brasileira, na década de 1950, além de ter influenciado na renovação do ensino de física no país.

Na sua primeira passagem pelo Brasil, Feynman veio a convite do físico brasileiro Jayme Tiomno, que conhecera na Universidade de Princeton (EUA). Permaneceu no Rio por seis semanas ministrando cursos no Centro Brasileiro de Pesquisas Físicas (CBPF). Na palestra “A eletrodinâmica quântica”, apresentada em português em seminário organizado pela Academia Brasileira de Ciências, descreveu os resultados obtidos por ele, Schwinger e Tomonaga.

Deu uma entrevista para um jornal carioca sobre eletrodinâmica quântica, a sua nova teoria do pósitron e a interação de partículas nucleares.

Nela, destacou seu apreço pelo novo núcleo de pesquisa em física, o CBPF, “formado por um grupo abnegado de pesquisadores, sob a direção do professor Cesar Lattes”.

Feynman afirmou: “Foi para mim um privilégio dar a minha colaboração a essa prestigiosa organização que, embora ainda em início, tantos serviços está prestando ao desenvolvimento da ciência no Brasil. Creio que o centro está destinado a grandes realizações em benefício do Brasil e da ciência, merecendo bem toda cooperação que lhe possam prestar o governo e a população”.

Dois anos depois, ele retornaria ao Brasil, em período sabático, após convite de José Leite Lopes, seu amigo e grande físico brasileiro, cujo centenário de nascimento também é comemorado neste ano. Feynman estava incomodado com o clima de falta de liberdade resultado do macartismo em seu país.

Atuou como professor no CBPF e na Universidade do Brasil (atual Universidade Federal do Rio de Janeiro), de setembro de 1951 a maio de 1952. Lecionou um curso de eletromagnetismo na graduação e outros dois, mais avançados, sobre física nuclear e eletrodinâmica quântica.

Apresentou duas comunicações cientificas em português na terceira Reunião Anual da Sociedade Brasileira para o Progresso da Ciência (SBPC), em Belo Horizonte. Em 1952, escreveu um trabalho sobre a teoria do méson, com Leite Lopes, e publicou depois, nos Anais da Academia Brasileira de Ciências, um interessante artigo de revisão sobre a situação da física teórica.

Em 1953, de novo no Brasil, fez pesquisas sobre a teoria atômica do hélio líquido que seriam publicadas em revistas internacionais em 1953 e 1954. Elas foram contribuições muito relevantes para o entendimento do estranho fenômeno de superfluidez que pode ocorrer com o hélio a temperaturas muito baixas.

Mas o acontecimento mais conhecido de Feynman no Brasil ocorreu em maio de 1952, quando fez, no Rio, uma palestra instigante sobre o ensino de física, com base em sua experiência na educação local. O destaque veio do relato feito em seu livro “O Senhor Está Brincando, Sr. Feynman!” (1985), que se tornou um best-seller mundial.

Feynman descreveu ali, de forma irônica, situações de sua interação com estudantes brasileiros que ilustravam sua crítica ao ensino da física baseado na memorização e sem a dimensão investigativa. Oswaldo Frota-Pessoa, biólogo brasileiro, escreveu em um artigo de jornal:

“Assisti [a] uma conferência espantosa. Um físico de fama mundial no setor da eletrodinâmica quântica, Richard P. Feynman, do CalTech (EUA), nos disse, em português claro, embora estropiado (um ano de Brasil), que, em verdade, não estamos ensinando ciência e nossos alunos não estão aprendendo. (…) E o pior é que ele tem toda a razão. Feynman é um homem raro: diz diretamente o que pensa e tudo o que pensa; e diz com tal entusiasmo e amor que se torna ao mesmo tempo contundente e encantador”.

Não foi pequeno o impacto que as observações de Feynman produziram. Leite Lopes mencionou que ele e Tiomno foram estimulados a fazer a tradução de um livro norte-americano para o ensino de física.

Alguns anos depois, em junho de 1963, Feynman voltaria a discutir o problema de ensinar física na América Latina em palestra na 1ª Conferência Interamericana de Ensino de Física, ocorrida no Rio.

Sua preocupação com o desenvolvimento da física no Brasil ficou evidente ao ajudar na recuperação da biblioteca do CBPF, destruída por um incêndio em 1959. Para isso, enviou uma carta a muitos de seus colegas dos EUA solicitando revistas científicas e livros para o novo prédio. Ele mesmo doou suas coleções de algumas das revistas científicas de física mais importantes da época.

As visitas de Feynman também contaram com momentos descontraídos. Encantou-se pelo Carnaval carioca, aprendeu a tocar frigideira, ensaiou durante meses e desfilou, em fevereiro de 1952, no bloco Os Farsantes de Copacabana, que ganhou o primeiro lugar de um desfile naquele ano.

Em fevereiro de 1966, já tendo recebido o Nobel, veio acompanhado de sua esposa, Gweneth, como convidado especial da Prefeitura do Rio de Janeiro. Folião animado e alegre, assistiu a desfiles e participou de alguns dos bailes mais famosos da cidade.

Feynman se dizia “utter ignoramus” (totalmente ignorante) em relação à política, mas se incomodava com a repressão às ideias e expressava preocupação com a democracia e os direitos humanos. Como exemplo disso, recusou convites para ir à União Soviética “por sentir-se desconfortável em um país onde havia perseguições por causa de ideias”.

Na sua vinda ao Brasil, em 1966, condenou, em entrevistas, as perseguições políticas a cientistas e físicos brasileiros, entre os quais mencionou seus colegas Mario Schenberg e José Leite Lopes. Talvez por antecipar uma possível crítica de Feynman à repressão política, foi suspensa, pelas autoridades aeronáuticas, a recepção com as escolas de samba que ele receberia ao desembarcar.

O Nobel de Física não retornaria mais ao Brasil.

As vindas de Richard Feynman deixaram marcas na física do país. Se os tempos ditatoriais não tivessem afastado das universidades e instituições de pesquisa alguns de seus amigos e colegas brasileiros, talvez este grande cientista tivesse colaborado de maneira mais acentuada para o desenvolvimento da ciência na terra de que tanto gostava.

Ildeu de Castro Moreira é professor do Instituto de Física da Universidade Federal do Rio de Janeiro e presidente da Sociedade Brasileira para o Progresso da Ciência (SBPC). Foi diretor do Departamento de Popularização e Difusão da Ciência e Tecnologia do MCTI (2004-2013). É autor de “Einstein e o Brasil” (Editora UFRJ).

Fonte: https://www1.folha.uol.com.br/ilustrissima/2018/05/o-nobel-que-ajudou-a-desenvolver-a-fisica-no-brasil-e-pulou-carnaval.shtml